✔Как найти дубли страниц с незначащими GET-параметрами — «Блог для вебмастеров»

Дубли страниц на сайте могут появиться в поиске вместо ценных страниц сайта или замедлить их обход и индексирование.

Вообще, дубли — это страницы сайта, содержание текста в которых полностью или практически совпадает. Страницы с GET-параметрами в URL тоже могут быть дублями. Если GET-параметр влияет на содержание страницы — это не дубль. А если GET-параметр не меняет контент страницы, то этот параметр называют незначащим и страницу стоит скрыть от поиска.

Расскажем подробнее, что такое незначащие GET-параметры, как найти дубли с такими параметрами и убрать их.

Что такое дубли страниц с незначащими GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Наличие дублей страниц с незначащими GET-параметрами не приносит пользы и может негативно сказаться на взаимодействии сайта с поисковой системой.

Зачем отслеживать дубли

1) Скорость обхода. Когда на сайте много дублей, роботы тратят больше времени и ресурсов на их обход, вместо того, чтобы обходить ценный контент. А значит, ценные страницы вашего сайта будут медленнее попадать в поиск.

2) Неуправляемость. Так как поисковой робот произвольно выбирает, какой из дублей показывать в поиске, то на поиск могут попасть не те страницы, которые вам нужны.

3) Влияние на поиск. Если незначащие параметры не добавлены в clean-param, робот может обходить эти страницы и считать их разными, не объединяя их в поиске. Тогда поисковый робот будет получать разные неагрегируемые сигналы по каждой из них. Если бы все сигналы получала одна страница, то она имела бы шансы показываться выше в поиске.

4) Нагрузка на сайт. Лишний обход роботом также дает нагрузку на сайт.

Например, на сайте по продаже билетов есть форма заявки на обратный звонок. При ее заполнении в url передается GET-параметр?form=show1, — он сообщает информацию о том, какой спектакль с этой страницы выбрал пользователь в заявке, хотя контент самой страницы никак не меняется. Таким образом, поисковой робот будет тратить время на обход множества одинаковых страниц, различающихся только GET-параметрами в URL, а до ценных страниц сайта доберется значительно позже.

Для интернет-магазинов типичный пример — страницы с фильтрами. Например, если пользователь выбирает товары в дорогом ценовом диапазоне, изменяя значения в фильтре «Цена», то в большинстве случаев ему будет показана страница с одними и теми же товарами. Таким образом, поиск будет получать сигналы о множестве одинаковых страниц, отличающихся только GET-параметром price= в URL.

Как обнаружить дубли

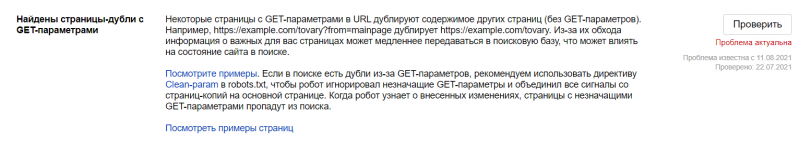

Теперь находить одинаковые страницы стало проще: в разделе «Диагностика» появилось специальное уведомление, которое расскажет про дубли из-за GET-параметров. Алерт появляется с небольшой задержкой в 2-3 дня, поэтому если вы увидели в нем исправленные страницы, не пугайтесь — это может быть связано с задержкой обработки данных. Дубли с параметром amp, даже если они у вас есть, мы не сможем показать в алерте.

Подписываться на оповещения не нужно, уведомление появится само. Если вы обнаружили дубли:

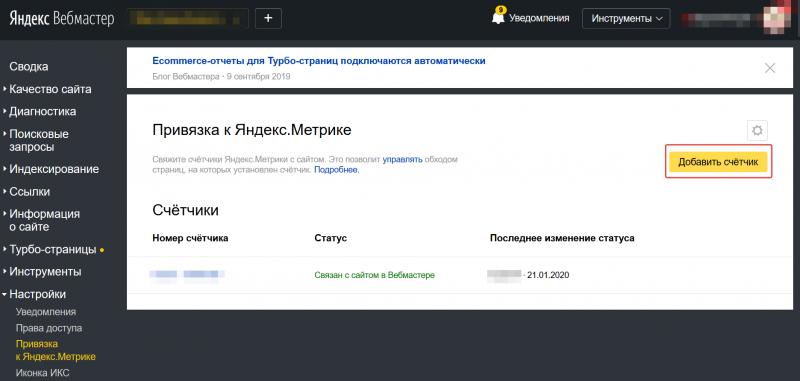

1. Перейдите в Вебмастер, откройте раздел Страницы в поиске, в таблице выберите Исключенные страницы.

2. Загрузите архив (подходящий формат можно выбрать внизу страницы) и просмотрите скачанный файл: у страниц-дублей будет статус DUPLICATE.

Как оставить в поиске нужную страницу

1. Добавьте в файл robots.txt директиву Clean-param, чтобы робот не учитывал незначащие GET-параметры в URL. Робот Яндекса, используя эту директиву, не будет много раз обходить повторяющийся контент. Значит, эффективность обхода повысится, а нагрузка на сайт снизится.

2. Если вы не можете добавить директиву Clean-param, укажите канонический адрес страницы, который будет участвовать в поиске. Это не уменьшит нагрузку на сайт: роботу Яндекса всё равно придётся обойти страницу, чтобы узнать о rel=canonical. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

3. Если по каким-то причинам предыдущие пункты вам не подходят, закройте дубли от индексации при помощи директивы Disallow. Но в таком случае поиск Яндекса не будет получать никаких сигналов с запрещенных страниц. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

Подробнее о работе со страницами-дублями читайте в Справке.

P. S. Подписывайтесь на наши каналы